Bildanalyse und Bildverstehen 1. Einleitung

Bildanalyse und Bildverstehen 1. Einleitung

Bildanalyse und Bildverstehen 1. Einleitung

Sie wollen auch ein ePaper? Erhöhen Sie die Reichweite Ihrer Titel.

YUMPU macht aus Druck-PDFs automatisch weboptimierte ePaper, die Google liebt.

<strong>Bildanalyse</strong> <strong>und</strong> <strong>Bildverstehen</strong><br />

<strong>1.</strong> <strong>Einleitung</strong><br />

"<strong>Bildverstehen</strong>"<br />

engl. "computer vision", "image <strong>und</strong>erstanding"<br />

<strong>Bildverstehen</strong> ist ein Prozess:<br />

• ausgehend von 1 oder mehreren Bildern <strong>und</strong> einer<br />

Fragestellung<br />

• Resultat ist eine Beschreibung<br />

(genaugenommen: Transformation einer Form von<br />

Beschreibung in eine andere)<br />

Bild ist oft 2D-Abbild einer realen 3D-Szene<br />

⇒ für die korrekte Beschreibung ist es oft nötig, diese<br />

Szene zu rekonstruieren<br />

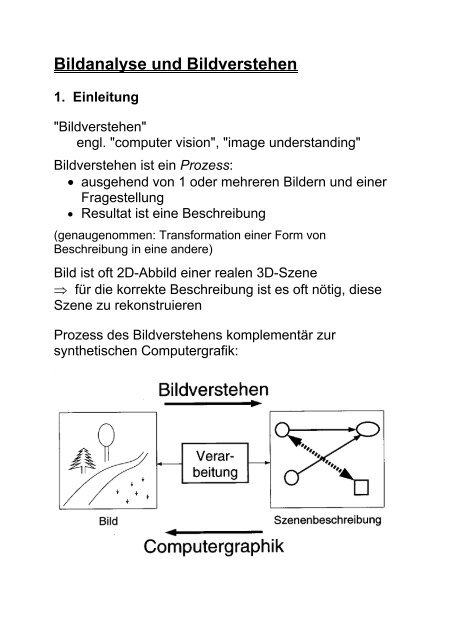

Prozess des <strong>Bildverstehen</strong>s komplementär zur<br />

synthetischen Computergrafik:

Definitionen des Prozesses "<strong>Bildverstehen</strong>" aus der<br />

Literatur:<br />

"Das Gewinnen einer Repräsentation der Form" (Marr)<br />

"Vom Bild zum Objektmodell" (Winston)<br />

"Die Bedeutung von Bildern mit Hilfe von exakt<br />

definierten Prozessen ermitteln" (Niemann & Bunke)<br />

"<strong>Bildverstehen</strong> ist die Rekonstruktion <strong>und</strong> Deutung einer<br />

Szene anhand von Bildern, so dass mindestens eine der<br />

folgenden operationalen Leistungen erbracht werden<br />

kann:<br />

• Ausgabe einer sprachlichen Szenenbeschreibung<br />

• Beantworten sprachlicher Anfragen bezügl. der<br />

Szene<br />

• kollisionsfreies Navigieren eines Roboters<br />

• planmäßiges Greifen <strong>und</strong> Manipulieren von<br />

Objekten in der Szene" (Neumann 1995)<br />

Verschiedene Ebenen von Realität:<br />

• physikalische Objekte einer Szene (Baum, Haus, Straße,<br />

Gully, Deckel, Loch, Regentropfen...)<br />

• Bilder der Szene (als Eingabe): Einzelbild, Stereo-<br />

Bildpaar, Bildfolge... je nach bildgebendem Verfahren<br />

• computerinterne Beschreibung der Szene (als Ausgabe):<br />

Listen, Merkmalsvektoren, komplexe Objekt- <strong>und</strong>/oder<br />

Szenenbeschreibungen ("is a"- oder "part of"-Hierarchien,<br />

Szenengraph, CSG-Modelle, Polygonnetze...)<br />

Ziele des <strong>Bildverstehen</strong>s:<br />

"Wo ist was"<br />

Wo: Rekonstruktion der Szenengeometrie (räumlich-zeitliche<br />

Information)<br />

Was: Deutung des Szeneninhalts (insbes.: Objekterkennung)

Die Art der gewünschten Beschreibung <strong>und</strong> Deutung<br />

hängt stark von der jeweiligen Fragestellung / vom<br />

Kontext ab.<br />

Beispiel:<br />

Mögliche Interpretationen dieses Bildes:<br />

(aus Pinz 1994)

• ein Binärbild (ein Bild mit nur 2 Grauwerten)<br />

• 3 Kreise, 1 Bogen <strong>und</strong> 20 Strecken<br />

• "Mensch" <strong>und</strong> "Auto"<br />

• ein lachender Mensch<br />

• ein Fußgänger überquert die Straße<br />

⇒<br />

es gibt keine allgemeingültige "korrekte" Arbeitsweise<br />

eines bildverstehenden Systems<br />

die korrekte Arbeitsweise hängt von der jeweiligen<br />

Fragestellung ab<br />

(aus Hermes 2001)

erforderliche Spezialleistungen, die das menschliche<br />

visuelle System "ohne Schwierigkeiten" erbringt:<br />

Ergänzen "subjektiver Konturen"

aktive Gruppierungsprozesse:<br />

Erkennen "subjektiver Objekte" (insbes. Gesichter,<br />

menschliche Figuren):

Wichtige Verarbeitungsschritte in bildverstehenden<br />

Systemen:<br />

<strong>1.</strong> Quantisierung der Ortskoordinaten

2. Bildvorverarbeitung:<br />

• Bildmodifikation, die den Informationsgehalt nicht<br />

wesentlich verändert<br />

• Bildtransformation mit Eingabe- <strong>und</strong> Ausgabebild<br />

• vgl. Vorlesung "Computergrafik", Kap. 14.<br />

Ziele:<br />

• Beleuchtungskorrekturen bei inhomogener<br />

Beleuchtung<br />

• Glättung<br />

• Beseitigung von Digitalisierungsfehlern<br />

• Kontrastverstärkung<br />

• Normierung (Größe, Form, Farben)<br />

• Beseitigung von Inhomogenitäten der Fotoschicht<br />

des Aufnahmesystems<br />

• Korrektur von Grauwertverzerrungen (fotografischer<br />

Effekt)<br />

• Ausgleich von kamerabedingten Verzerrungen<br />

• selektive Filterung bestimmter Frequenzen

3. Segmentation (auch Segmentierung):<br />

• Trennung der zu untersuchenden Objekte von den<br />

übrigen Bildstrukturen<br />

• Trennung von sich berührenden Objekten<br />

voneinander<br />

• Zerlegung in Teilobjekte<br />

• Klassifikation auf Pixelebene (Objektpixel /<br />

Nichtobjektpixel)<br />

⇒ geeignete Merkmale auf Pixelebene?<br />

• einfache <strong>und</strong> komplexe Verfahren

Zerlegung des Bildes in zu interessierende Strukturen<br />

(Objekte) <strong>und</strong> nicht zu interessierende Strukturen<br />

(Hintergr<strong>und</strong>) gemäß:<br />

• Diskontinuitätskriterium (Kanten)<br />

• Homogenitätskriterium (Intensitätswert, Farbe)<br />

• hybride Verfahren (Kombination z.B. durch Region-<br />

Growing-Verfahren, vgl. Saatfüll-Algorithmus der<br />

2D-Computergrafik)

4. Merkmalsextraktion<br />

Flächen:<br />

Intensitätswert / Farbe<br />

Umfang, Größe<br />

Schwerpunkt<br />

Hauptachsen<br />

Polygonzerlegung<br />

...<br />

Konturen:<br />

Kettencode<br />

Polygon<br />

Länge<br />

Orientierung<br />

...<br />

Texturen:<br />

statistische Merkmale<br />

visuelle Eigenschaften<br />

...<br />

statistische Merkmale:<br />

Informationsgehalt, Momente (Mittelwert, Varianz,<br />

Schiefe, Kurtosis... einer Verteilung), Anzahl der Pixel

5. Klassifikation<br />

Wie löst das menschliche visuelle System diese<br />

Aufgaben?<br />

Biologische Gr<strong>und</strong>lagen

Die Großhirnrinde:<br />

Teile des Körpers entsprechen bestimmten<br />

sensorischen <strong>und</strong> motorischen Feldern der<br />

Großhirnrinde: besonders empfindliche Regionen<br />

werden auf relativ große Bereiche abgebildet

Die Sehbahn beginnt im Auge (vgl. Vorlesung<br />

Computergrafik, Kap. 2a)<br />

Aufgabe der Augen: auf beiden Netzhäuten ein klares,<br />

scharfes Bild festhalten<br />

• 3 Muskelpaare; Nachführen der Augen in wenigen<br />

Bogenminuten<br />

• Hornhaut (Cornea) <strong>und</strong> Linse dienen der<br />

Scharfstellung<br />

• Durchmesser der Pupille bestimmt einfallende<br />

Lichtmenge (Öffenen <strong>und</strong> Schließen durch spezielle<br />

Muskelfasern)<br />

• Selbstreinigungsfunktion

Die Netzhaut (Retina):<br />

wandelt Lichtsignale in Nervensignale (elektrische<br />

Signale) um<br />

unterscheidet verschiedene Wellenlängen<br />

breiter Arbeitsbereich (Sonnenlicht / Sternenlicht)<br />

Präzision: aus ca. 1 m Entfernung kann noch ein Haar<br />

gesehen werden

Netzhaut ist Teil des Gehirns (verb<strong>und</strong>en über den<br />

Sehnerv)<br />

Dicke ¼ mm<br />

3 Schichten Nervenzellen + 2 Zwischenschichten<br />

Photorezeptoren: Zapfen <strong>und</strong> Stäbchen<br />

Stäbchen für Dämmerungssehen, Zapfen für Farbsehen<br />

in der Mitte der Retina (Fovea centralis) nur Zapfen<br />

Zellreihe hinter den Photorezeptoren enthält Farbstoff<br />

Melanin (schluckt einfallendes Licht)<br />

Schichten vor den Rezeptoren sind nahezu durchsichtig

Rezeptives Feld:<br />

Gesamtfläche der Rezeptoren auf der Netzhaut, die auf<br />

eine Ganglienzelle abbilden<br />

• das rezeptive Feld beeinflusst das Feuern dieser<br />

Ganglienzelle<br />

• Spontanentladung (unregelmäßig) 1–20 mal pro<br />

Sek.<br />

• Verschaltung variiert von der Fovea bis zum Rand<br />

der Netzhaut<br />

Entdeckung von Kuffler (1950) bei systematischem<br />

Absuchen der Netzhaut mit kl. Lichtfleck:<br />

On-Zentrum- <strong>und</strong> Off-Zentrum-Neuronen<br />

On-Zentrum: erhöhte Impulsrate, wenn das Zentrum des<br />

rezeptiven Feldes mit Lichtfleck gereizt wird ("On-<br />

Reaktion")<br />

Off-Zentrum: Unterdrückung der Aktivität, starke<br />

Entladung nach Ausschalten des Lichtreizes ("Off-<br />

Reaktion")<br />

je mehr von bestimmter On/Off-Region mit passendem<br />

Stimulus bedeckt, desto heftiger die Reaktion

je tiefer man ins Zentralnervensystem vordringt, desto<br />

komplexer die rezeptiven Felder der einzelnen Neuronen<br />

Überlappung einzelner rezeptiver Felder von<br />

benachbarten Ganglienzellen<br />

auch die Bipolarzellen besitzen rezeptive Felder

noch nicht vollständig geklärt: Funktionen der Horizontal<strong>und</strong><br />

Amakrinzellen<br />

Chiasma opticum: Sehnervkreuzung<br />

beide Sehnerven teilen sich auf beide Gehirnhälften auf<br />

"seitliche Kniehöcker": Zwischenverarbeitungsbereich<br />

zwischen Chiasma <strong>und</strong> visuellem Cortex<br />

Farbsehen durch 3 verschiedene Nervenzellenklassen<br />

Visueller Cortex (Sehrinde):<br />

6 Schichten<br />

• simple cells: sensitiv gegenüber Lichtschlitz, Balken,<br />

Gerade<br />

• complex cells: sensitiv gegenüber kurzem<br />

Aufleuchten <strong>und</strong> evtl. Bewegung<br />

• hyper complex cells: sensitiv gegenüber Bewegung<br />

<strong>und</strong> Orientierung<br />

Zusammenfassung zur Sehbahn:<br />

• Hierarchischer Aufbau<br />

• massiv parallele Signalverarbeitung<br />

• Datenreduktion bei Merkmalsextraktion<br />

• viele Einzelheiten noch ungeklärt

2 Ansätze zur Untersuchung der Funktionsweise des<br />

visuellen Systems:<br />

• bottom-up: von einzelnen Neuronen <strong>und</strong> ihrer<br />

Funktion ausgehend (siehe oben)<br />

• top-down: von den Wahrnehmungsleistungen<br />

ausgehend (Versuchspersonen) – kognitive<br />

Psychologie, Gestaltwahrnehmung<br />

idealerweise sollten sich beide Ansätze "in der Mitte<br />

treffen" – davon ist man noch weit entfernt<br />

Gruppierungsprinzipien der Gestaltwahrnehmung<br />

(vgl. Vorlesung Computergrafik, Kap. 2a):<br />

(aus Pinz 1994)<br />

f): kontinuierl. Fortsetzung gruppiert stärker als Symmetrie

Es gibt auch Merkmale, die vom menschlichen visuellen<br />

System schlecht extrahiert werden können, z.B.<br />

Kollinearität:<br />

Gestaltwahrnehmung berücksichtigt automatisch<br />

Tiefeneffekte, was zu "optischen Täuschungen" führen<br />

kann (eigentl. Täuschungen des visuellen Systems,<br />

entstehen bei der neuronalen Verarbeitung):

wie rekonstruiert das menschl. visuelle System<br />

Bildinformationen? Hinweise aus Versuchsreihen:<br />

was ist das?<br />

Die meisten Testpersonen benötigen zum Erkennen<br />

eines Objekts mehr als 1 Minute.

Hier sind die Erkennungszeiten deutlich niedriger,<br />

obgleich nur 1 Strich (rechts unten) hinzugefügt wurde:<br />

Vermutung:<br />

Das zusätzliche Linienstück ermöglicht eine höhere<br />

Wahrscheinlichkeit für eine kreisförmige Gruppierung;<br />

von da aus wird schrittweise weiter rekonstruiert<br />

(Kreis → Rad → Fahrrad).

Gr<strong>und</strong>lage der maschinellen Bildauswertung:<br />

Bildgebende Verfahren<br />

schon hier Unterschied zum menschlichen Sehen –<br />

Kamera sieht anders als das Auge<br />

Wichtige bildgebende Verfahren (nur grober Überblick):

Computertomografie

3D-Scanner:<br />

- verschiedene Techniken der Tiefengewinnung

Zeilenkamera<br />

(Zeile mit CCD-Elementen – lichtempfindliche Sensoren)<br />

für Fernerk<strong>und</strong>ung oft 3 parallele Zeilen:<br />

Luftbild unkorrigiert / korrigiert:

auch für terrestrische Aufnahmen / Gebäude- <strong>und</strong><br />

Innenraum-Rekonstruktion, Archäologie:<br />

Panoramakamera des<br />

DLR<br />

3D-Rekonstruktion von Teilen<br />

des Pergamon-Altars

Flachbettscanner<br />

(aus http://www.mathematikphysik.de/computer/compdoc1/docs/lac08_scannen.pdf)