Artificial Intelligence

DeepMind erstellt KI, die Erinnerungen wie den Hippocampus wiedergibt

Das menschliche Gehirn erinnert sich oft (scheinbar) unaufgefordert an vergangene Erinnerungen. Im Laufe des Tages erleben wir spontane Erinnerungsblitze aus unserem Leben. Während diese spontane Beschwörung von Erinnerungen schon seit langem für Neurowissenschaftler von Interesse ist, hat das KI-Forschungsunternehmen DeepMind kürzlich die Aufmerksamkeit auf sich gezogen veröffentlichte ein Papier detailliert beschrieben, wie eine ihrer KI dieses seltsame Erinnerungsmuster nachgeahmt hat.

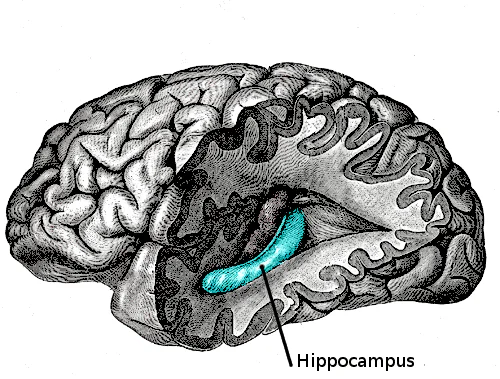

Die Beschwörung von Erinnerungen im Gehirn, die neuronale Wiedergabe, ist eng mit dem verbunden Hippocampus. Der Hippocampus ist eine seepferdchenförmige Formation im Gehirn, die zum limbischen System gehört und mit der Bildung neuer Erinnerungen sowie den Emotionen, die diese Erinnerungen auslösen, in Verbindung gebracht wird. Aktuelle Theorien zur Rolle der Hippocampi (es gibt einen in jeder Gehirnhälfte) besagen, dass verschiedene Regionen des Hippocampus für die Verarbeitung unterschiedlicher Arten von Erinnerungen verantwortlich sind. Man geht beispielsweise davon aus, dass das räumliche Gedächtnis im hinteren Bereich des Hippocampus abgewickelt wird.

Wie von Jesus Rodriguez berichtet, Dr. John O'Keefe ist für viele Beiträge zu unserem Verständnis des Hippocampus, einschließlich des Hippocampus, verantwortlich Zellen „platzieren“. Die Ortszellen im Hippocampus werden durch Reize in einer bestimmten Umgebung ausgelöst. Experimente an Ratten zeigten beispielsweise, dass bestimmte Neuronen feuerten, wenn die Ratten bestimmte Abschnitte einer Strecke durchliefen. Die Forscher beobachteten die Ratten weiterhin, auch wenn sie ruhten, und stellten fest, dass die gleichen Muster von Neuronen, die einen Teil des Labyrinths kennzeichnen, feuerten, obwohl sie mit erhöhter Geschwindigkeit feuerten. Die Ratten schienen die Erinnerungen an das Labyrinth in ihren Gedanken noch einmal durchzuspielen.

Beim Menschen ist das Abrufen von Erinnerungen ein wichtiger Teil des Lernprozesses, aber wenn man versucht, KI zum Lernen zu befähigen, ist es schwierig, dieses Phänomen nachzubilden.

Das DeepMind-Team machte sich daran, das Phänomen der Erinnerung mithilfe von Reinforcement Learning nachzubilden. Reinforcement-Learning-Algorithmen funktionieren, indem sie Feedback aus ihren Interaktionen mit der Umgebung um sie herum einholen und immer dann belohnt werden, wenn sie Maßnahmen ergreifen, die sie dem gewünschten Ziel näher bringen. In diesem Zusammenhang zeichnet der Reinforcement-Learning-Agent Ereignisse auf und spielt sie dann zu einem späteren Zeitpunkt ab, wobei das System verstärkt wird, um die Effizienz beim Abrufen vergangener Erfahrungen zu verbessern.

DeepMind fügte die Wiedergabe von Erfahrungen zu einem Reinforcement-Learning-Algorithmus hinzu, indem es einen Wiedergabepuffer nutzte, der Erinnerungen/aufgezeichnete Erfahrungen zu bestimmten Zeiten im System wiedergab. Bei einigen Versionen des Systems wurden die Erlebnisse in zufälliger Reihenfolge abgespielt, während bei anderen Modellen die Abspielreihenfolge voreingestellt war. Während die Forscher mit der Reihenfolge der Wiedergabe der Verstärkungsmittel experimentierten, experimentierten sie auch mit verschiedenen Methoden zur Wiedergabe der Erfahrungen selbst.

Es gibt zwei Hauptmethoden, die verwendet werden, um Verstärkungsalgorithmen mit erinnerten Erfahrungen zu versorgen. Diese Methoden sind die Imaginationswiedergabemethode und die Filmwiedergabemethode. Das DeepMind-Papier verwendet eine Analogie, um beide Strategien zu beschreiben:

„Angenommen, Sie kommen nach Hause und stellen zu Ihrer Überraschung und Bestürzung fest, dass sich auf Ihren schönen Holzböden Wasser sammelt. Als Sie das Esszimmer betreten, finden Sie eine kaputte Vase. Dann hörst du ein Wimmern und siehst aus der Terrassentür, dass dein Hund sehr schuldbewusst dreinschaut.“

Wie Rodriguez berichtet, zeichnet die Imaginationswiedergabemethode die Ereignisse nicht in der Reihenfolge auf, in der sie erlebt wurden. Vielmehr wird auf eine wahrscheinliche Ursache zwischen den Ereignissen geschlossen. Die Ereignisse werden auf der Grundlage des Weltverständnisses des Agenten abgeleitet. Währenddessen speichert die Filmwiedergabemethode Erinnerungen in der Reihenfolge, in der die Ereignisse stattgefunden haben, und spielt die Reihenfolge der Reize ab – „verschüttetes Wasser, zerbrochene Vase, Hund“. Die chronologische Reihenfolge der Ereignisse bleibt erhalten.

Forschungen aus dem Bereich der Neurowissenschaften legen nahe, dass die Filmwiedergabemethode ein wesentlicher Bestandteil der Schaffung von Assoziationen zwischen Konzepten und der Verbindung von Neuronen zwischen Ereignissen ist. Doch die Imaginationswiederholungsmethode könnte dem Agenten helfen, neue Sequenzen zu erstellen, wenn er durch Analogien argumentiert. Zum Beispiel könnte der Agent zu dem Schluss kommen, dass, wenn ein Fass zum Ölen verwendet wird wie eine Vase zum Gießen, ein Fass von einem Fabrikroboter und nicht von einem Hund verschüttet werden könnte. Als DeepMind die Möglichkeiten der Imagination-Replay-Methode weiter untersuchte, stellten sie tatsächlich fest, dass ihr Lernagent in der Lage war, beeindruckende, innovative Sequenzen zu erstellen, indem er frühere Erfahrungen berücksichtigte.

Die meisten aktuellen Fortschritte im Bereich der Stärkung des Lerngedächtnisses werden mit der Filmstrategie erzielt, obwohl Forscher kürzlich damit begonnen haben, Fortschritte bei der Imaginationsstrategie zu machen. Die Erforschung beider Methoden des KI-Gedächtnisses kann nicht nur eine bessere Leistung von Reinforcement-Learning-Agenten ermöglichen, sondern uns auch dabei helfen, neue Erkenntnisse darüber zu gewinnen, wie der menschliche Geist funktionieren könnte.